Chapter 5 モデル非依存(Model-Agnostic)な手法

機械学習モデルから説明性を分離すること(=モデル非依存な解釈手法)には、いくつかの利点があります (Ribeiro, Singh, and Guestrin 201626)。 モデル固有の解釈手法と比べて、モデルに非依存な解釈手法の大きな利点は柔軟性があることです。 解釈手法がどのようなモデルにも適用できるならば、機械学習の開発者は好きな機械学習モデルに対して思いのまま使うことができます。 また、可視化の結果やユーザーインタフェースのような機械学習モデルの解釈を基に構築されるものは、根底にある機械学習モデルから独立したものになります。 通常、ある課題を解決するために機械学習モデルは1種類ではなく、多くの種類のモデルを評価します。 そして解釈性という観点でモデルを比較する際には、どのような種類のモデルに対しても同じ手法を用いることができるため、モデル非依存な手法を用いると簡単になります。

モデル非依存な解釈手法の代わりに解釈性のあるモデルのみを使用する方法がありますが、その場合は他の機械学習モデルと比較して予測性能が低い傾向があるという大きな欠点があり、使用するモデルが1種類に限定されることになります。 他の代替案は、モデル固有の解釈方法をつかうことです。 これの欠点は、やはり1種類のモデルに制限されてしまうことと、後から他のモデルに切り替えることが難しくなることです。

モデル非依存な解釈手法には、次のような性質が望まれます (Ribeiro, Singh, and Guestrin 2016)。

- モデルの柔軟性 (Model flexibility) モデルの解釈手法がランダムフォレストやディープニューラルネットワークといったあらゆる機械学習モデルに対して使用できること。

- 説明の柔軟性 (Explanation flexibility) モデルの説明が特定の形式に制限されることがないこと。線形の関係を持つことが役に立つかもしれませんし、特徴量の重要度を可視化することが有用な場合もあるでしょう。

- 表現の柔軟性 (Representation flexibility) 説明のシステムは、説明対象のモデルとは異なる特徴量の表現を使用できるべきです。抽象的な単語埋め込みベクトルを使用したテキスト分類に対しては、個々の単語を用いて説明することが好ましいかもしれません。

全体像

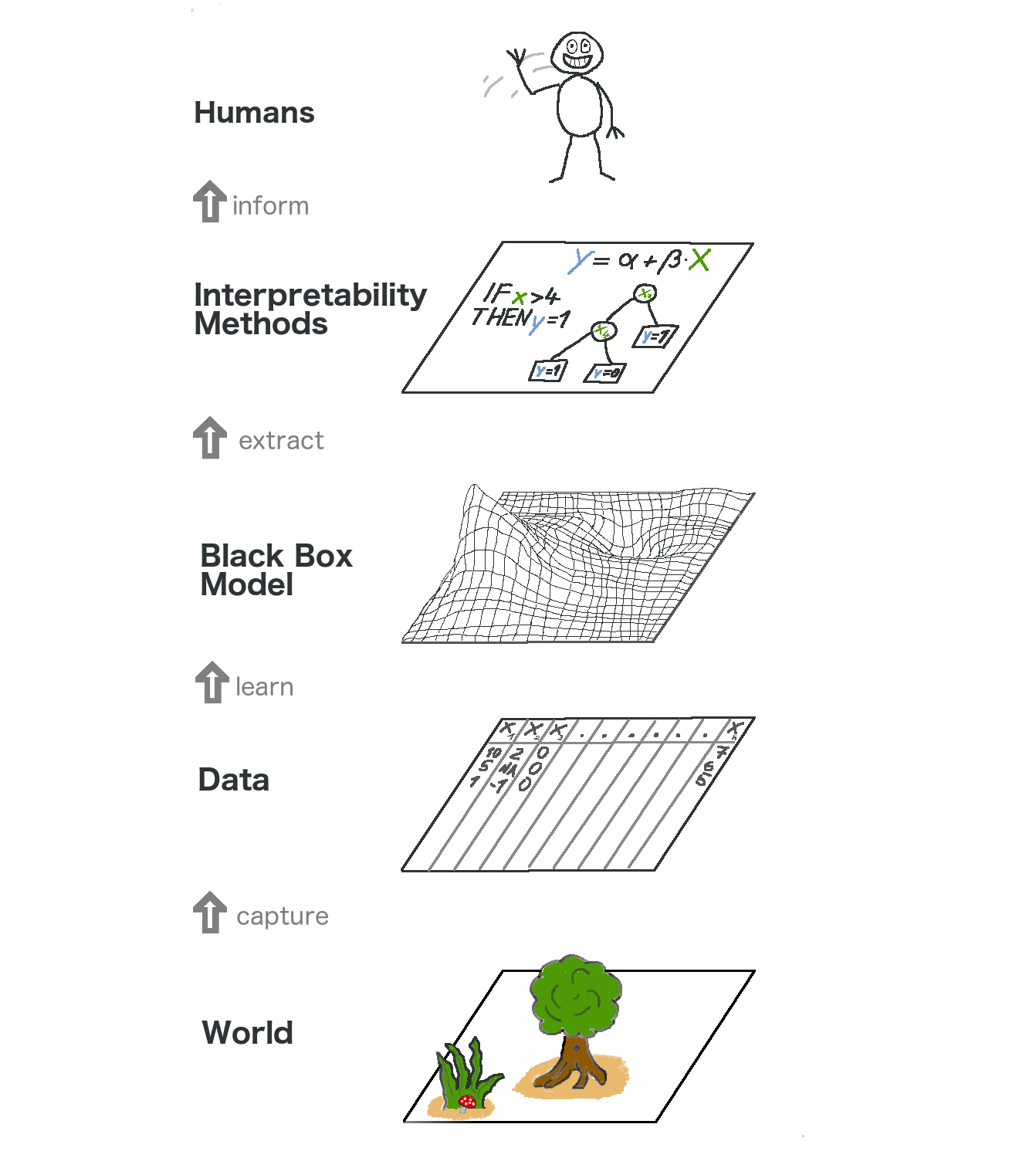

モデル非依存な解釈性を高い視点で見てみましょう。 私たちはデータを集めることで現実世界を捉え、(課題のために)機械学習モデルを用いてデータを予測するために学習し、さらに抽象化します。 解釈性は、人間の理解の助けとなる頂上のもう1つの層です。

FIGURE 5.1: 説明可能な機械学習の全体像。説明が人間に届く前に、現実世界はいくつかの層を通過します。

最も下に位置する層は現実世界です。 これは文字通り人体の生物学や薬に対する反応といった自然そのものを指すこともありますが、不動産市場といったより抽象的なことを指すこともあります。 現実世界の層には観察対象や興味の対象となりうるものすべてが含まれます。 最終的に私たちは現実世界に関する何かを学び、そして世界と対話することを目標としています。

2番目に位置する層はデータの層です。 コンピュータで情報を処理し保存するためには、現実世界はデジタル情報へと変換される必要があります。 データ層には画像やテキスト、表データなどが含まれています。

機械学習モデルをデータ層から学習させることで、ブラックボックスモデルの層が生まれます。 機械学習アルゴリズムは現実世界のデータから学習し、予測を出力したり何らかの構造を見つけ出したりします。

ブラックボックスモデルの層の上には解釈手法の層があり、機械学習モデルの不透明性に対処する助けとなります。 ある診断結果において最も重要な特徴量は何でしょうか。 なぜ金融取引が詐欺と分類されたのでしょうか。

最後の層は人間によって構成されています。 見てください!ここに描かれた人物はあなたに手を振っています! あなたがこの本を読むことがブラックボックスモデルに対してより良い説明を与える手助けとなっているからです!

この多層から成る抽象化は統計学者と機械学習を実践している人のアプローチの違いを理解することにも役立ちます。 統計学者は臨床試験の計画や調査の設計などデータ層を扱っています。 彼らはブラックボックスモデルの層を飛ばし、直接解釈手法の層へと進みます。 機械学習のスペシャリストも同様にラベリングされた皮膚がんの画像を収集したり、ウィキペディアから情報を集めるなど、データ層を扱っています。 その後、彼らはブラックボックスな機械学習モデルを学習させます。 解釈手法の層は飛ばされ、人間が直接ブラックボックスモデルの予測と向き合います。 機械学習モデルを解釈可能とすることは統計学者と機械学習のスペシャリストの成果を融合させる素晴らしいことなのです。

もちろんこの図が全てを捉えているわけではありません。 データはシミュレーションから得られることもあります。 またブラックボックスモデルの出力する予測が他の機械へと与えられるのみで人間に届かないこともあります。 しかし全体として見るならば、この抽象化は解釈可能性が機械学習モデルの上に位置する新しい層となることを上手く表現しています。

Ribeiro, Marco Tulio, Sameer Singh, and Carlos Guestrin. "Model-agnostic interpretability of machine learning." ICML Workshop on Human Interpretability in Machine Learning. (2016).↩